1. 피드 포워드 신경망 (Feed Forward Neural Network)

2. 잔차 연결 (Residual Connection) 과 레이어 정규화 (Layer Normalization)

2.1. 잔차 연결 (Residual Connection)

2.2. 레이어 정규화 (Layer Normalization)

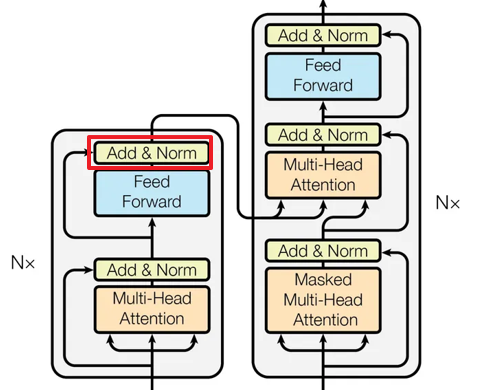

트랜스포머의 마지막 포스팅 입니다. 피드 포워드 신경망, 잔차 연결, 레이어 정규화에 대해서 알아보겠습니다.

1. 피드 포워드 신경망 (Feed Forward Neural Network)

트랜스포머 모델 내의 각 인코더와 디코더 레이어는 피드포워드 신경망(FNN)을 포함하고 있습니다. FNN은 인코더와 디코더의 각 레이어에서 입력을 받아 비선형 변환을 수행하는 완전 연결 네트워크입니다. 구체적으로, FNN은 두 개의 선형 변환과 그 사이에 위치하는 활성화 함수(예: ReLU)로 구성됩니다.

FNN은 어텐션 레이어의 출력에서 나온 정보를 처리하여, 각 위치의 숨겨진 상태를 독립적으로 업데이트 하여, 각 위치의 정보를 더 풍부하고 복잡한 표현으로 변환해주는 역할 수행합니다.

2. 잔차 연결 (Residual Connection) 과 레이어 정규화 (Layer Normalization)

2.1. 잔차 연결 (Residual Connection)

잔차 연결은 트랜스포머 모델의 각 서브 레이어(어텐션과 FNN)의 입력과 출력 사이에 추가됩니다. 간단히 말해, 입력이 서브 레이어의 처리 과정을 거친 후, 원래의 입력과 출력이 합쳐지는 방식입니다.

잔차 연결은 깊은 네트워크에서 그래디언트가 효과적으로 전파되도록 돕는 역할을 수행합니다. 이를 통해 모델이 깊어질 때 발생할 수 있는 학습 문제(예: 그래디언트 소실)를 완화하고, 학습 과정을 안정화시킵니다.

2.2. 레이어 정규화 (Layer Normalization)

레이어 정규화는 각 서브 레이어의 출력 후에 적용됩니다. 이는 서브 레이어의 출력을 정규화하여, 특정 범위 내의 값을 유지하도록 조정합니다.

레이어 정규화는 모델의 훈련을 더 안정적이고 빠르게 만드는 역할을 수행합니다. 각 레이어의 입력이 정규화되므로, 학습 중 발생할 수 있는 값의 급격한 변동을 방지하고, 더 빠른 수렴을 돕습니다.

이상 9개의 포스팅을 통해 트랜스포머에 대해서 자세히 알아보았습니다.

트랜스포머에 대해서 자세한 사항이 궁금하시면 아래 링크에 있는 포스팅을 확인 해보시면 됩니다.

트랜스포머

2. 트랜스포머 구조 (Transformer High-level Architecture)

3. 트랜스포머 구조 상세 (Transformer Detailed Architecture)

4. 트랜스포머 훈련과 예측 단계 (Transformer Learning and Inference Step)

5. 트랜스포머 입력과 출력 (Transformer Input and Output)

6. 어텐션, 셀프 어텐션, 멀티 헤드 어텐션 개요 (Transformer Attention, Self Attention, Multi-head Attention)

7. 셀프 어텐션 상세 동작 과정 (Transformer Self Attention Detailed Process)

8. 멀티 헤드 어텐션 상세 동작 과정 (Transformer Multi-head Attention Detailed Process)

BERT

Comment