1. 트랜스포머

2. 트랜스포머의 장점

3. 트랜스포머의 단점

4. 트랜스포머의 주요 구성 요소

4.1. 어텐션 메커니즘(Attention Mechanism)

4.2. 멀티-헤드 어텐션(Multi-Head Attention)

4.3. 포지셔널 인코딩(Positional Encoding)

4.4. 인코더와 디코더 블록(Encoder & Decoder Blocks)

4.5. 피드포워드 신경망(Feed-Forward Neural Networks)

LLM 알고리즘의 시초 트랜스포머(Transformer)에 대해서 알아보곘습니다.

트랜스포머의 개요 부터 시작해서 트랜스포머의 주요 엔티티 및 알고리즘까지 포스팅이 이어지겠습니다.

1. 트랜스포머

2017년 Google Research에서 발표한 자연어 처리 모델

- "Attention is All You Need"라는 논문에서 처음 제안

- 논문 제목처럼 Attention 매커니즘을 이용

- 주로 언어 번역, 문장 생성, 요약 등의 작업에 사용

2. 트랜스포머의 장점

- 병렬 처리 가능: RNN과 달리 트랜스포머는 시퀀스 내 모든 요소를 동시에 처리할 수 있어, 효율적이고 빠른 학습이 가능

- 장거리 의존성 학습: 문장 내 멀리 떨어진 요소들 간의 관계도 잘 파악

- 확장성: 큰 모델과 데이터에도 잘 확장되어, 더 정확한 결과를 낼 수 있음

3. 트랜스포머의 단점

- 높은 계산 비용: 트랜스포머 모델은 어텐션 메커니즘을 사용하기 때문에 높은 계산 비용이 발생할 수 있음

- 긴 문장 처리 어려움: 트랜스포머 모델은 긴 문장을 처리하기 위해서는 많은 메모리가 필요하기 때문에 긴 문장 처리에 어려움이 있을 수도 있음

- 해석 가능성의 부족: 내부 작동 방식이 복잡하여 결과 해석이 어려울 수 있음

4. 트랜스포머의 주요 구성 요소

4.1. 어텐션 메커니즘(Attention Mechanism)

- 특정 단어가 문장 내 다른 단어와 얼마나 관련이 있는지 파악

- '셀프 어텐션(Self-attention)'은 한 문장 내에서 단어 간의 관계 파악

- 해당 메커니즘을 통해 모델은 문맥을 더 잘 이해할 수 있음

4.2. 멀티-헤드 어텐션(Multi-Head Attention)

여러 어텐션 메커니즘을 병렬로 사용하여 다양한 문맥 관점에서의 정보 수집

4.3. 포지셔널 인코딩(Positional Encoding)

트랜스포머는 기본적으로 순서에 대한 정보를 가지고 있지 않기 때문에, 각 단어의 위치 정보를 모델에 추가하는 방식을 이용

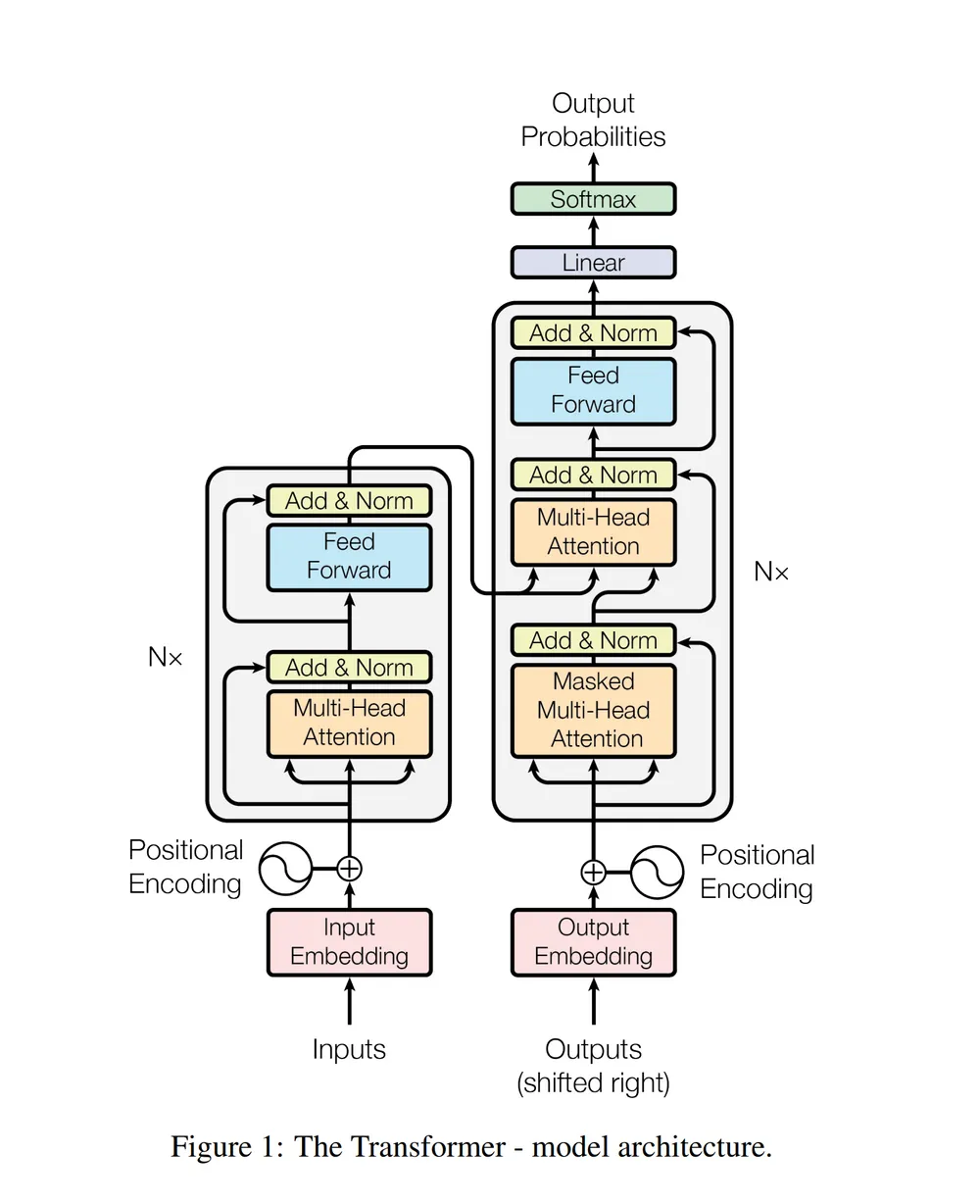

4.4. 인코더와 디코더 블록(Encoder & Decoder Blocks)

- 인코더는 입력 문장을 처리하고, 디코더는 인코더의 출력을 바탕으로 새로운 문장을 생성

- 각 블록은 여러 층으로 구성되어 있으며, 각 층은 멀티-헤드 어텐션과 피드포워드 신경망으로 구성

4.5. 피드포워드 신경망(Feed-Forward Neural Networks)

어텐션 층의 출력을 처리하여 최종 출력 생성

이상 트랜스포머가 어떤 모델인지에 대한 대략적인 개요를 살펴보았습니다.

다음 포스팅에서는 트랜스포머에 대해서 좀 더 깊게 파고들어 보겠습니다.

트랜스포머

2. 트랜스포머 구조 (Transformer High-level Architecture)

3. 트랜스포머 구조 상세 (Transformer Detailed Architecture)

4. 트랜스포머 훈련과 예측 단계 (Transformer Learning and Inference Step)

5. 트랜스포머 입력과 출력 (Transformer Input and Output)

6. 어텐션, 셀프 어텐션, 멀티 헤드 어텐션 개요 (Transformer Attention, Self Attention, Multi-head Attention)

7. 셀프 어텐션 상세 동작 과정 (Transformer Self Attention Detailed Process)

8. 멀티 헤드 어텐션 상세 동작 과정 (Transformer Multi-head Attention Detailed Process)

BERT

Comment